Matemáticas para hacer frente a los retos de la medicina personalizada

El avance en el conocimiento del genoma humano ha sido firme 20 años después de su secuenciación completa, pero aún quedan muchas cuestiones por resolver

En junio del año 2000, con el esplendor propio de los grandes momentos, el presidente de Estados Unidos Bill Clinton anunció –junto con el primer ministro británico Tony Blair– la finalización de la secuenciación completa del genoma humano, el “diseño genético de los seres humanos”. Se vaticinaba una revolución en el conocimiento del fundamento genético de los caracteres biológicos que nos definen, entre ellos, las enfermedades. Desde aquella presentación, ¿qué ha pasado? ¿En qué etapa se encuentra la medicina personalizada? Y ¿qué tienen que ver las matemáticas en todo esto?

La estrategia parecía clara. Si hasta entonces se sabía que unos pocos genes afectan ciertos aspectos de nuestra biología, la disponibilidad de todo el genoma permitiría extender ese conocimiento a situaciones en que los caracteres fueran determinados por numerosos genes. Los primeros son los llamados caracteres simples y, los segundos, complejos. Equivalentemente, las enfermedades determinadas por unos pocos genes (o un único gen) se conocen como mendelianas (por ejemplo, la fibrosis quística), y como no mendelianas, aquellas relacionadas con muchos (por ejemplo, la hipertensión).

Ahora bien, la secuencia de un mismo gen puede cambiar en cada persona y esto modifica asimismo sus caracteres (altura, susceptibilidad a hipertensión, etc.). Lo ideal, entonces, no es simplemente emparejar genes a caracteres, sino asociar secuencias concretas –variantes de un mismo gen– a la magnitud de los mismos. Si obtuviéramos esta relación alcanzaríamos dos objetivos. El primero es que entenderíamos mejor el fundamento biológico de esa propiedad. El segundo es que podríamos predecirla en aquellos individuos que presentaran la secuencia especifica identificada. Ambos aspectos contribuirían al desarrollo de la medicina personalizada.

Sin embargo, pese al abaratamiento de la secuenciación (en el año 2000 eran unos 300 millones de dólares; hoy, 1.000 dólares), secuenciar el genoma de muchas personas –lo cual es necesario para poder hacer la asociación secuencia a carácter– es todavía complicado. Los experimentos GWAS (del inglés, genome-wide association studies) ofrecen una alternativa: secuenciar exclusivamente las regiones del genoma en las que se exhibe el tipo de variabilidad genética más frecuente. Estas regiones se llaman SNPs (del inglés single nucleotide polymorphisms) y solo contienen un nucleótido, el constituyente básico del genoma, que puede presentar cuatro estados diferentes, abreviados G, A, T, C.

La variación en un SNP no tiene por qué ser la causa de la presencia, o modificación, de la propiedad biológica correspondiente. Los SNPs actúan en la mayoría de los casos como “señalizadores” de la existencia, cercana físicamente en el genoma de variantes genéticas que sí son las auténticas causas. Esto es debido al “ligamiento” que existe entre secuencias cercanas físicamente en el genoma humano, conocido como desequilibrio de ligamiento.

Mediante metodologías especiales para examinar estas regiones, más baratas y fáciles, se pueden evaluar en torno a un millón de SNPs por individuo. Sin embargo, los primeros trabajos fueron incapaces de identificar los conjuntos de SNPs vinculados a la variabilidad encontrada en los caracteres complejos o en la susceptibilidad a enfermedades no mendelianas. Para nuestro asombro, parece que la mayoría de los aspectos propios de la biología humana están determinados por muchísimos más SNPs y con una influencia mucho más débil de los que esperábamos. Estos SNPs aparecen distribuidos además por todo el genoma.

Por otro lado, desde la secuencia del genoma a la manifestación del aspecto biológico existen niveles intermedios de actividad molecular, que modulan la posible expresión de ese aspecto, lo que complica más aún el entendimiento de esta relación. Esto último se conoce como el problema del mapa genotipo-fenotipo.

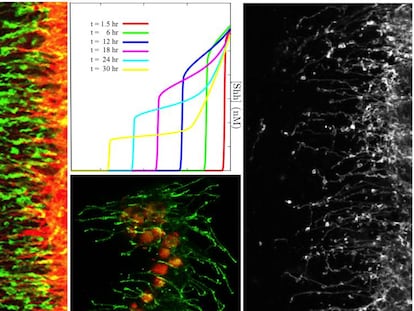

Y es aquí donde entran las matemáticas. El impulso de métodos cuantitativos permite entender mejor la asociación entre secuencia y carácter biológico, incorporando información del contexto molecular y celular, en forma de redes genéticas. Por ejemplo, estas técnicas hacen posible identificar SNPs cuya variación se asocia significativamente con la susceptibilidad frente a una enfermedad. Entre estas herramientas encontramos modelos simples de regresión y metodologías más complejas que incorporan estimación bayesiana y, más recientemente, el uso de redes neuronales profundas e inferencia causal.

En cuanto al segundo objetivo que exponíamos, el de la predicción, las matemáticas se emplean para desarrollar sistemas que vaticinen el valor de un carácter dado a partir de información de la secuencia individual. Para ello se está agregando toda la información de los SNPs disponibles, teniendo en cuenta la intensidad de su efecto, en un único “predictor” de riesgo poligénico. A medida que mejora su capacidad de pronóstico, muchos proponen su uso como biomarcadores independientes y para la clasificación de la gravedad de los pacientes. Sin embargo, también tienen limitaciones: nuestro entendimiento del funcionamiento de estos predictores es muy reducido, dado lo enmarañado del mapa genotipo-fenotipo descrito. Además, su desarrollo depende de la población concreta bajo examen (y de las interacciones dependientes del ambiente entre genes) y es así difícilmente generalizable.

Los predictores de riesgo poligénico representan entonces un ejemplo más –en genómica– de los desafíos a los que se enfrentan otras disciplinas cuyo objetivo es la predicción cuantitativa a partir del llamado big data. Estas herramientas desempeñan su labor, pero no percibimos bien el porqué. Warren Weaver, uno de los pioneros de la teoría de la información, resaltó en su escrito sobre Ciencia y Complejidad (de 1947) que este tipo de desafíos, a los que denominó de complejidad “organizada”, serían los que dominarían la ciencia y tecnología futura. Profundizar en ellos mediante el uso de las matemáticas marcará sin ninguna duda el avance y éxito de la codiciada medicina personalizada, pero deberíamos siempre tener presente las restricciones ineludibles que impone la complejidad.

Juan F. Poyatos dirige el laboratorio de Lógica de los Sistemas Genómicos en el Centro Nacional de Biotecnología, integrado en la conexión LifeHUB del Consejo Superior de Investigaciones Científicas, y es investigador visitante del ICMAT.

Café y Teoremas es una sección dedicada a las matemáticas y al entorno en el que se crean, coordinado por el Instituto de Ciencias Matemáticas (ICMAT), en la que los investigadores y miembros del centro describen los últimos avances de esta disciplina, comparten puntos de encuentro entre las matemáticas y otras expresiones sociales y culturales y recuerdan a quienes marcaron su desarrollo y supieron transformar café en teoremas. El nombre evoca la definición del matemático húngaro Alfred Rényi: “Un matemático es una máquina que transforma café en teoremas”.

Edición y coordinación: Ágata A. Timón G Longoria (ICMAT).

Puedes seguir a MATERIA en Facebook, Twitter e Instagram, o apuntarte aquí para recibir nuestra newsletter semanal.

Tu suscripción se está usando en otro dispositivo

¿Quieres añadir otro usuario a tu suscripción?

Si continúas leyendo en este dispositivo, no se podrá leer en el otro.

FlechaTu suscripción se está usando en otro dispositivo y solo puedes acceder a EL PAÍS desde un dispositivo a la vez.

Si quieres compartir tu cuenta, cambia tu suscripción a la modalidad Premium, así podrás añadir otro usuario. Cada uno accederá con su propia cuenta de email, lo que os permitirá personalizar vuestra experiencia en EL PAÍS.

En el caso de no saber quién está usando tu cuenta, te recomendamos cambiar tu contraseña aquí.

Si decides continuar compartiendo tu cuenta, este mensaje se mostrará en tu dispositivo y en el de la otra persona que está usando tu cuenta de forma indefinida, afectando a tu experiencia de lectura. Puedes consultar aquí los términos y condiciones de la suscripción digital.