Hablar con la máquina

La tecnología de reconocimiento de voz transforma nuestro modo de relacionarnos con los dispositivos

Cada 10 años cambia la forma en que interactuamos con la tecnología. Primero llegaron los ordenadores de sobremesa, después los buscadores de Internet y en 2007 los teléfonos inteligentes transformaron nuestra manera de comunicarnos. Pero ¿cuál es el siguiente paso? La respuesta a esa pregunta la dio Phil Schiller, vicepresidente de marketing de Apple, en 2011. “Lo único que queríamos era hablar a nuestros dispositivos, hacerles preguntas sencillas y que nos dieran una respuesta. Queríamos poder hablar con ellos como con cualquier persona”. Efectivamente, el siguiente paso en la evolución de la tecnología es la voz.

En aquella comparecencia de 2011, Schiller presentó al mundo a Siri, el primer asistente virtual activado por voz de la historia. Siete años después, 710 millones de personas utilizan y hablan con estos ayudantes 2.0 al menos una vez al mes, según la consultora Tractica, y se calcula que en 2018 los ayudantes virtuales alcanzarán los 1.000 millones de usuarios. El habla es la manera más natural que tenemos los humanos de interactuar. Si aplicamos este modo de comunicarnos a nuestra relación con los dispositivos electrónicos, el paradigma de la relación entre los usuarios y las máquinas cambiará por completo.

Al implantar la voz como interfaz para interactuar con las máquinas ya no habrá que esforzarse por entender su funcionamiento, saber dónde clicar para buscar una foto o tener acceso directo al correo en la pantalla principal del teléfono. Solo tendremos que decir: “Manda un mensaje a mi jefe diciéndole que llego tarde” o “enséñame las fotos de mi sobrino”. Dicho y hecho. Será un modo de democratizar el acceso a la información y a las nuevas tecnologías, eliminando, de paso, la brecha tecnológica generacional.

Si aplicamos este modo de comunicarnos a nuestra relación con los dispositivos electrónicos, el paradigma de la relación entre los usuarios y las máquinas cambiará por completo.

Este cambio no sería posible sin la tecnología de reconocimiento del lenguaje, que es la capacidad que tienen las máquinas para procesar la información que les damos a través de la voz. Si se lo pedimos, son capaces de buscar el mejor restaurante de la ciudad o poner el despertador para el día siguiente a las nueve de la mañana. Esto genera la falsa sensación de que el asistente nos entiende y de que sabe a qué nos referimos. Nada más lejos de la realidad: cada vez que hacemos una pregunta a Google o a Siri, es el ayudante el que convierte nuestra voz en texto y ese texto, a su vez, en lenguaje binario, para así poder procesar la información y buscar en sus bases de datos la mejor respuesta. Esta tecnología ya está completamente desarrollada en inglés: diferentes empresas como Google o la consultora Accenture apuntan que la comprensión del lenguaje natural en este idioma es efectiva en un 95%-99%; mientras que en castellano todavía queda mucho por mejorar, ya que tan solo es efectiva en un 80%-85%.

La integración total del lenguaje natural en los asistentes virtuales nos acerca un poco más a aquella promesa que hizo Phil Schiller. Aunque estos ayudantes nunca llegarán a sustituir una conversación con otra persona, algunas empresas están creando la ilusión de que sí es posible a través de aplicaciones como Xiaoice (desarrollado por Microsoft para China). Hay que recordar que las máquinas no son capaces de entender lo que decimos y que las respuestas que nos dan, ingeniosas, divertidas o cortantes, son fruto de una base de datos preescrita por periodistas, guionistas y lingüistas. No hay ninguna espontaneidad. No son capaces de crear lenguaje.

La combinación de estas dos tecnologías con el Internet de las cosas ha dado lugar a nuevos artilugios, como la torre de Amazon (más conocida como Alexa), el Google Home o el Apple Pod, que prometen hacernos la vida mucho más fácil: desarrollarán por nosotros tareas tan cotidianas como encender la calefacción o poner en tu televisión inteligente tu serie favorita sin que haya que levantarse del sofá. ¿Cómo? Solamente habrá que pedírselo.

Es el parámetro biomédico más seguro. “Con solo decir ‘mi voz es mi contraseña’, la maquina reconoce al cliente”, explica Marco Piña

Las emociones de la voz

El siguiente paso para hacer más "real" la relación entre seres humanos y máquinas es que estas últimas sean capaces de reconocer las emociones que sienten sus dueños para ofrecer una experiencia más completa.

Gemma García López, investigadora internacional de la UCM- Standford University asegura que con el software de reconocimiento de emociones, las máquinas como los asistentes podrían ofrecer respuestas dependiendo de los diferentes estados de ánimo. Por poner un ejemplo práctico, se podría preguntar a Siri qué estrenos hay para hoy y si detectase que el usuario está triste podría sugerir en primer lugar algunas comedias.

Aunque la aplicación de esta clase de softwares es muy complejo, ya que la fugacidad de las emociones hace que sea complicado establecer un patrón que se mantenga en el tiempo, como pueden ser por ejemplo los gustos del dueño del asistente, matiza García López.

Estas torres cuentan con una serie de micrófonos que están constantemente “escuchando” lo que ocurre a su alrededor y en el momento en el que captan el comando de activación se ponen a nuestro servicio. El primero de los dilemas que plantean estos aparatos es ¿qué pasa con mi privacidad? ¿Dónde van todas esas conversaciones que mi asistente escucha a lo largo del día? “Son desechadas”, asegura Behshad Behzadi, uno de los ingenieros principales de Google Assistant, en videoconferencia desde la sede de la empresa en Zúrich, “aunque el asistente esté todo el día escuchando, esa información no se envía a ninguna parte. El ayudante de Google solo se activa en el momento en el que dices ‘Ok Google’ y a partir de ahí sí que recoge tus peticiones y las envía”. Una parte de su retentiva es privada, y solo se utiliza para almacenar datos personales de su dueño.

Gracias a esta memoria pueden saber cuál es nuestro equipo de fútbol favorito, dónde vivimos o en qué empresa trabajamos. Nuestros dispositivos inteligentes tendrán pronto un acceso total a nuestra vida y a nuestra información.

Entonces, ¿qué pasa con nuestros datos? ¿Quién tendrá acceso a ellos? ¿Dónde los alojarán las grandes empresas? ¿Podrán ser hackeados? Son algunas de las preguntas que surgen cuando se habla de información personal. En principio, según explica Isabel Fernández, directora general de Accenture Analytics, “no será posible acceder a los datos personales de los usuarios porque solo se compartirán los comandos que se utilizan para pedirle cosas al asistente y siempre de manera anónima”.

La seguridad es otro de los campos en los que la tecnología de reconocimiento de voz promete ser relevante. “La voz, al igual que las huellas dactilares, es única en cada persona”, explica Marco Piña, director de Nuance Enterprise Iberia en una entrevista en la sede de la empresa en Madrid. Esta característica permite que se pueda emplear como elemento de seguridad para, por ejemplo, poder hacer transacciones con el banco sin necesidad de contraseñas. “Esta tecnología ya está implantada en varios países de América Latina y en Reino Unido, y es muy efectiva. La voz es el parámetro biométrico más seguro, y con solo decir ‘mi voz es mi contraseña’, la máquina detecta que el cliente es quien está hablando y da luz verde a la operación”.

Nada, o casi nada, puede engañar a estos softwares de reconocimiento de voz, ni siquiera una grabación de altísima calidad. “Cuando hablamos, nuestra voz emite una serie de parámetros que son únicos. Cuando esa voz es reproducida después de ser grabada, esos parámetros varían, de una manera mínima, pero varían, y el programa reconoce que no está hablando con una persona real. Pero para asegurarse, pide que repita otra frase aleatoria. Es imposible que nadie tenga todas las frases del mundo grabadas, por lo que no se puede engañar al software”.

Al igual que en la película Her, donde un hombre acaba enamorado de la voz de su máquina, podremos mantener conversaciones con nuestros asistentes personales, nos recordarán que nos toca tomar la medicación e incluso parecerá que nos escuchan cuando les contemos que hemos tenido un mal día.

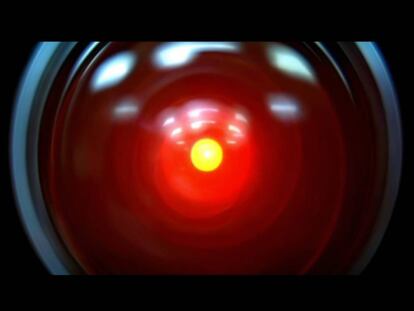

Pero siempre habrá que tener en cuenta que detrás de esa voz que nos responde desde el iPhone o el Google Home solo hay unos y ceros siendo procesados a gran velocidad.

Tu suscripción se está usando en otro dispositivo

¿Quieres añadir otro usuario a tu suscripción?

Si continúas leyendo en este dispositivo, no se podrá leer en el otro.

FlechaTu suscripción se está usando en otro dispositivo y solo puedes acceder a EL PAÍS desde un dispositivo a la vez.

Si quieres compartir tu cuenta, cambia tu suscripción a la modalidad Premium, así podrás añadir otro usuario. Cada uno accederá con su propia cuenta de email, lo que os permitirá personalizar vuestra experiencia en EL PAÍS.

En el caso de no saber quién está usando tu cuenta, te recomendamos cambiar tu contraseña aquí.

Si decides continuar compartiendo tu cuenta, este mensaje se mostrará en tu dispositivo y en el de la otra persona que está usando tu cuenta de forma indefinida, afectando a tu experiencia de lectura. Puedes consultar aquí los términos y condiciones de la suscripción digital.