Mastodon: qué es y cómo funciona la red social en la que los usuarios deciden qué está permitido

La plataforma absorbe a algunos internautas desencantados con Twitter tras la compra de Elon Musk

El caos provocado tras la compra de Twitter por parte de Elon Musk ha disparado la emigración de usuarios a Mastodon, que el pasado domingo superó los dos millones de usuarios mensuales activos. “El futuro de las redes sociales no tiene que pertenecer a un multimillonario, puede estar en manos de sus usuarios”, tuiteó Mastodon. Entre las principales diferencias de esta plataforma con Twitter, está la moderación de contenidos, en la que los propios usuarios fijan las reglas y juegan un papel fundamental.

¿Cómo funciona Mastodon?

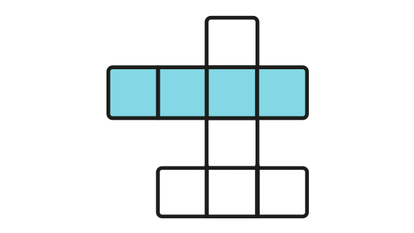

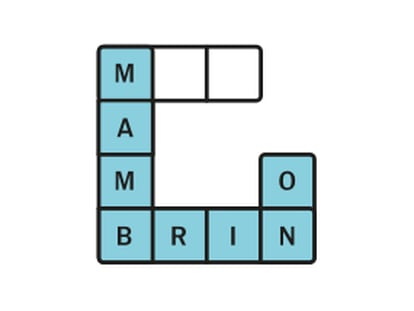

“Mastodon no es solo un sitio web como Twitter o Facebook, es una red de miles de comunidades operadas por diferentes organizaciones e individuos que brindan una experiencia fluida en las redes sociales”, afirman sus creadores. Se trata de una aplicación descentralizada y de código abierto en la que los usuarios se agrupan en comunidades o “instancias” de múltiples temáticas y características: de las relacionadas con la tecnología, los juegos, el activismo o el arte a las de personas trans y los defensores de la privacidad o de la libertad de expresión.

Tras descargar la aplicación, es posible escoger de qué instancia formar parte. También hay una web que permite buscar comunidades en función del idioma y el número de usuarios. Al hacer una búsqueda, es posible encontrar instancias “para todos los que persiguen la ética periodística”, “con temática de terror para todos los mutantes” o “para frikis de todas las tendencias”.

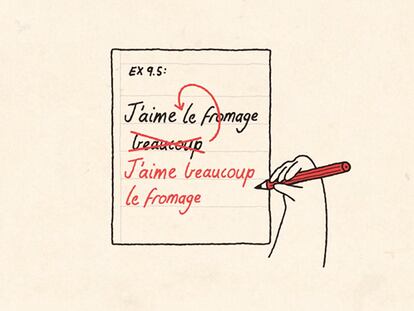

Una vez que se está dentro de una instancia, el funcionamiento y la interfaz de la app son bastante similares a Twitter. Es posible seguir a otros usuarios, responder a las publicaciones, compartirlas o marcarlas como favoritas. No obstante, también hay algunas diferencias: los mensajes en Mastodon pueden tener hasta 500 caracteres, frente a los 280 de Twitter.

¿Cómo se realiza la moderación de contenidos?

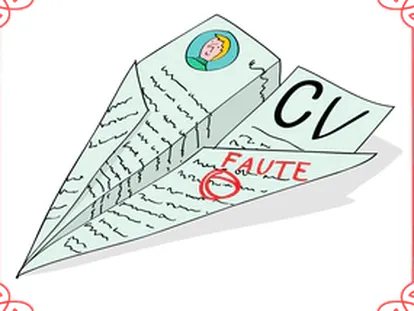

Saber cómo funciona Mastodon es importante para comprender cómo se hace la moderación de contenidos. Cada instancia tiene sus propias normas y su equipo de moderación. “En teoría, hay tantas condiciones legales como instancias, ya que cada una tiene sus servidores, sus administradores y, por tanto, sus reglas”, explica Fernando Suárez, presidente del Consejo General de Colegios Profesionales en Ingeniería Informática.

Es decir, “los moderadores son los propios usuarios, pero en el seno de su propia instancia”. Por lo tanto, un tipo de discurso puede estar permitido en un servidor, pero no estarlo en otro diferente. Si alguien no tiene en cuenta las normas de una instancia, los administradores podrían silenciarlo (ocultar su cuenta a los demás usuarios en ese servidor) o expulsarlo.

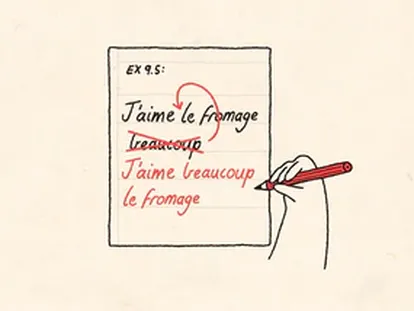

El imparable crecimiento de Mastodon ha venido acompañado de algunos fallos en la moderación. “En 13 años en Twitter nunca me han quitado una publicación, y en tres semanas en Mastodon ya me han quitado algo por racismo y sexismo”, señala una usuaria en Twitter. El tuit retirado era el siguiente: “Durante los últimos años, he estado leyendo casi exclusivamente libros de autores no masculinos, no blancos y no heterosexuales (o alguna combinación de ellos) y me ha encantado, pero ahora estoy pensando que necesito volver a los autores blancos heterosexuales para estudiar la psicología de los hombres blancos ricos que tienen el poder sobre todos nosotros”.

Esta usuaria publicó este mensaje en mastodon.social, una instancia generalista administrada por Eugen Rothko, el desarrollador original de Mastodon y un pequeño equipo de colegas. Desde Mastodon han reconocido que esta publicación fue eliminada por error: “Recientemente, contratamos a más moderadores y la publicación en cuestión se interpretó falsamente como si implicara algo que no era”. Rothko anunció hace una semana que había contratado moderadores de contenido para su instancia, pero cada caso es diferente y muchas carecen de recursos para pagar a los moderadores.

¿Es posible garantizar la ausencia de mensajes racistas u homófobos en Mastodon?

“Como cada una de las instancias se autogestiona, lo que se haga en una instancia es lo que quienes la montan quieran”, afirma Fernando Muñoz, socio del Grupo Raíz Digital, una agencia especializada en la moderación de contenidos digitales. En teoría, todos los servidores de Mastodon se comprometen a demostrar una “moderación activa contra el racismo, el sexismo, la homofobia y la transfobia”. “Los usuarios deben tener la confianza de que se unen a un espacio seguro, libre de la supremacía blanca, antisemitismo y transfobia de otras plataformas”, explican desde Mastodon.

Mastodon has just passed over 2 million active monthly users, a new record! People are voting with their feet. The future of social media doesn't have to belong to a billionaire, it can be in the hands of its users.

— Mastodon (@Mastodon@mastodon.social) (@joinmastodon) November 20, 2022

Pero, si los moderadores son los propios usuarios, ¿podría pasar que un grupo de personas racistas cree una instancia y permita que en ella se difundan mensajes de odio o bulos? “Poder podría, pero contravendría las propias reglas de la creación de las instancias de Mastodon”, responde Muñoz. Este problema no es nuevo. Gab, una red social de extrema derecha conocida como un espacio de reunión para los supremacistas blancos, se convirtió en 2019 en la instancia más grande de Mastodon, según recoge el portal Vice.

Mastodon emitió un comunicado en el que criticaba que Gab usara la plataforma y aseguraba que haría todo lo que estuviera a su alcance para aislar esta instancia. “No fue un movimiento bienvenido por nuestra parte; sin embargo, la licencia bajo la que publicamos nuestro software permite a cualquiera usarlo como le parezca, siempre y cuando mantenga la misma licencia y haga públicas sus modificaciones”, indicó.

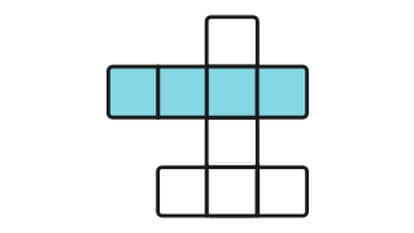

¿Cómo pueden actuar otras instancias frente a este tipo de contenidos?

“Mastodon es una tecnología, como los foros o el correo electrónico, que cualquiera puede crear para comunicar las ideas que desee, incluso las dañinas o las que incitan al odio”, afirma Kit Walsh, abogado de la Electronic Frontier Foundation, una de las principales organizaciones sin ánimo de lucro dedicada a defender las libertades civiles en el mundo digital. Según destaca, “no hay una sola parte que controle el uso de la tecnología y que pueda imponer restricciones de contenido, sino que cada foro o servidor de correo electrónico tendrá administradores que controlen esa comunidad en particular”.

Si hay una instancia problemática, los administradores de otras comunidades podrían bloquearla para que sus usuarios no puedan ver su contenido e interaccionar con ella. “Este tipo de bloqueo con respecto a los servidores es muy común y forma parte de la manera en que cada nodo [o instancia] establece los límites para proteger a sus usuarios”, señala Walsh. Hay quienes comparten información sobre instancias problemáticas “utilizando el hashtag #fediblock y explican por qué no se debe confiar en ellas”. Al buscar este hashtag en Mastodon, algunos usuarios denuncian instancias por “insultos y racismo” o por “difundir contenido malicioso”.

Que unas comunidades puedan bloquear a otras, según Muñoz, podría provocar que, por ejemplo, varias instancias con contenido fascista pudieran interactuar entre ellas pero no con el resto, “aumentando así el filtro burbuja”. Walsh subraya que algunos servidores adoptan un enfoque cauteloso y solo aceptan comunicaciones de una “lista blanca” de instancias que saben que son de confianza. Lo ideal, según la EFF, sería encontrar una instancia en la que se esté de acuerdo con las políticas de moderación. El usuario puede cambiarse en cualquier momento a otra que encaje más con sus preferencias o tenga una moderación más activa.

Puedes seguir a EL PAÍS TECNOLOGÍA en Facebook y Twitter o apuntarte aquí para recibir nuestra newsletter semanal.

Sobre la firma