¿Aceptaría que le ‘lean’ la cara en cualquier momento?

Un equipo de investigación de la UE identifica las aplicaciones de procesamiento facial que deberían prohibirse, limitarse y autorizarse

/cloudfront-eu-central-1.images.arcpublishing.com/prisa/IBWR4VRMOVESTDPOVEBJ4EOBGU.JPG)

Advierte Felipe Gómez-Pallete, presidente de Calidad y Cultura Democráticas, que “la tecnología, una vez desarrollada, no hay quien la pare”. Y añade: “La podemos regular, atemperar, pero llegamos tarde”. Es el caso de las tecnologías de procesamiento facial, las que leen y analizan nuestros rostros con decenas de intenciones, desde comerciales o de seguridad hasta de ayuda a personas invidentes o con alzhéimer. La Comisión Europea ha elaborado una propuesta de regulación de la inteligencia artificial (AI Act) con el fin de superar esta brecha y adelantarse a aquellos avances que supongan un riesgo “alto o inaceptable” para los derechos fundamentales sin lastrar su desarrollo. Para aportar la información científica necesaria, el proyecto europeo Humaint, del Centro Común de Investigación, (JRC por sus siglas en inglés), ha elaborado un exhaustivo informe en el que identifica 187 empresas que desarrollan tecnologías de procesamiento facial, cómo son, cómo se usan y cuáles deberían estar prohibidas, limitadas o permitidas: un semáforo orientativo para que, esta vez, se llegue a tiempo. El trabajo ha sido publicado en Scientific Reports.

Cualquier usuario estará familiarizado con las tecnologías que permiten el acceso a nuestro móvil con reconocimiento facial o las que se aseguran en una frontera de que el titular de un pasaporte coincide con la imagen impresa en el mismo. Parecen pocas, pero son más habituales de lo que parece. Humaint se ha centrado en 60 usos generalizados y de tecnologías maduras ya asentadas o acreditadas que permiten desde conocer la reacción de un consumidor ante un producto a seguir el rastro de un desaparecido o localizar a un sospechoso de un crimen o detectar la somnolencia de un conductor. Pero también las que facilitan identificar a alguien en un espacio y con quién está o catalogar a las personas por su etnia, edad o sexo o vigilar sus comportamientos en un examen o una reunión. Es necesario saber qué se puede hacer con estas tecnologías y qué utilidades deben prohibirse o limitarse.

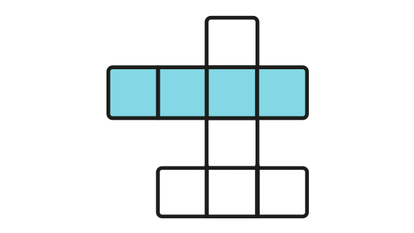

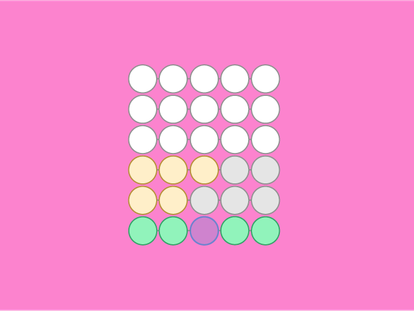

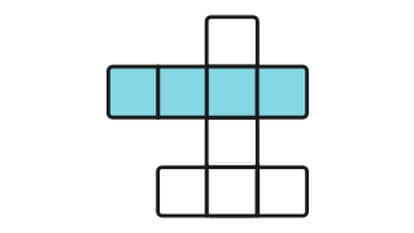

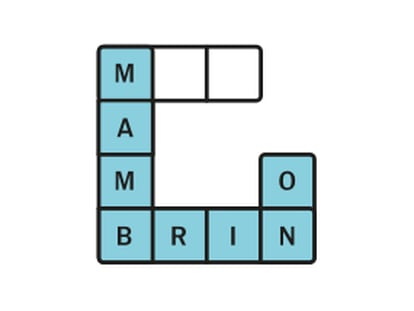

Para facilitar la regulación, el grupo de investigación del JRC ha elaborado un semáforo de cuatro colores que corresponden a los niveles de riesgo definidos por el AI Act: negro para los usos que deberían prohibirse, rojo para los que entrañan riesgos y deben someterse a requisitos estrictos, amarillo para los que deben incluir advertencias a los usuarios y verdes para aquellas con riesgo mínimo. Algunas utilidades rozan los límites de lo permisible y comparten colores en función de cómo se implementen.

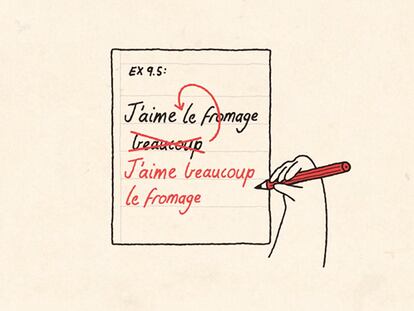

Isabelle Hupont, coautora de la investigación, aclara que hay también que distinguir entre procesamiento facial y utilizar la biometría para identificar personas: “Podemos analizar el rostro, sus expresiones, sin identificar a la persona. Esto se utiliza mucho en técnicas de mercado para ver la reacción ante un producto o un anuncio. También se puede ver si, en una situación de pandemia, las personas llevan mascarilla, pero sin identificarlas”

Alto riesgo. Entre las aplicaciones negras y rojas (prohibidas o de alto riesgo) se encuentran las de seguimiento con cámaras personales, drones o robots o los reconocimientos faciales sin restricciones, la búsqueda injustificada de personas o su seguimiento, la catalogación a través de imágenes personales, la identificación de clientes para darles un trato especial o la localización de usuarios de redes sociales y contactos.

“Es importante la proporcionalidad, porque se pueden utilizar para determinados casos, como amenazas terroristas o búsqueda de desaparecidos, delincuentes peligrosos y personas reclamadas por la justicia”, aclara Songül Tolan, también coautora de la investigación.

En este sentido, Emilia Gómez, coordinadora del proyecto Humaint, señala cómo el uso de reconocimiento facial para el control de acceso puede entrañar riesgos que varían, por ejemplo, si se cuenta o no con la autorización previa del usuario.

Transparentes. Entre las aplicaciones catalogadas como amarillas, las que exigen transparencia o información de su uso a las personas, se encuentran las de análisis demográficos, detección de características personales (sexo o rango de edad, por ejemplo), sonrisas, personalización de anuncios, medida de la satisfacción de clientes o la experiencia emocional de un videojuego.

En este grupo, según detalla Hupont, entrarían los deepfakes (montajes audiovisuales hiperrealistas) o los chatbots, interlocutores artificiales. En ambos casos, según la investigadora, “debe decirse claramente que es una imagen creada por inteligencia artificial o que no hay un humano conversando”.

Permitidas. Los usos que suponen un riesgo bajo son los de accesos en fronteras, autentificación bancaria o para trámites oficiales, desbloqueo de dispositivos, protección perimetral, interacción emocional artística, control de pandemias y aforos, emparejamiento de una imagen real con un retrato robot o aquellas que supongan la participación consentida y voluntaria del usuario.

De nuevo, las líneas no son claras. Hay sistemas que permiten a un invidente saber quiénes están con él y la posición que ocupan. U otras que permiten a un paciente de alzhéimer reconstruir su día, con quién ha estado, para minimizar los fallos de memoria. También a los autistas les puede facilitar la mejora en las capacidades emocionales. Pero esas mismas aplicaciones, con un uso distinto a aquel para el que han sido diseñadas, pueden pasar a rojas, a peligrosas y limitables. Ha sido el caso de los programas pensados para favorecer la motivación del alumnado en función de sus reacciones y que se usaron para el control y vigilancia durante exámenes y clases a través de internet.

Hay muchos usos que ayudan a las empresas o a la gente, que mejoran la vida. Hay que mostrarlos también porque los avances en esta tecnología no son siempre negativosSongül Tolan, coautora de la investigación del JRC

“Hay muchos usos que ayudan a las empresas o a la gente, que mejoran la vida. Hay que mostrarlos también porque los avances en esta tecnología no son siempre negativos. Estos hay que regularlos, pero también apoyar el desarrollo de estos sistemas”, comenta Tolan.

La propuesta europea para evitar estas zonas de colores difuminados es que todas las aplicaciones de procesamiento facial de alto riesgo cuenten con una autorización previa, con un sello que garantice una serie de requerimientos que resume Emilia Gómez: “Disponer de un sistema de gestión de riesgos, transparencia y comunicación, documentación técnica y registros, adecuada gobernanza de los datos, vigilancia humana, precisión, solidez y ciberseguridad”.

La transparencia se refiere a la claridad de todo el sistema desde su gestación hasta su implantación para comprobar intenciones, usos, sesgos o disfunciones, que sean evaluables y se sometan a seguimiento; sólidos y seguros implica que no sean manipulables o susceptibles de fallos; y robustos, que sean eficaces ante ciberataques. En este sentido, Hupont señala cómo la incorporación intencionada de un elemento que impida el reconocimiento (conocido como patrón adversarial) puede impedir una identificación, por ejemplo, de una señal de tráfico por parte de un vehículo con un sistema de reconocimiento por imagen.

También señala la investigadora que el principio de vigilancia humana propuesto es que haya, para reconocimiento facial, un mínimo de dos personas detrás de cada sistema y Gómez añade que puede obligarse a que el usuario de la aplicación esté siempre identificado y autentificado.

Tres modelos

Estos serían los pilares básicos de la propuesta de regulación para las tecnologías de procesamiento facial, pero Songül Tolan advierte que no se puede garantizar al 100% un uso adecuado. Para ello, Emilia Gómez añade que tendrá que haber legislaciones complementarias sobre la responsabilidad de las deficiencias, que los ciudadanos denuncien cualquier situación de abuso o discriminación que se genere a partir de estas tecnologías y que la justicia se adapte a esta realidad en la que Europa es vanguardia en cuanto a regulación, aunque no en cuanto a desarrollo.

En este sentido, la investigación detalla cómo es Estados Unidos el país a la cabeza de la creación de aplicaciones de procesamiento facial, con un gran peso de las grandes compañías privadas. Europa, que se sitúa en segunda posición, presenta un ecosistema más vinculado a pequeñas y medianas empresas mientras China, que ocupa el tercer lugar, cuenta con un panorama singular concentrado en pocas grandes empresas vinculadas al Gobierno.

Esta radiografía es fundamental porque la clave está en la titularidad de las bases de datos. A mayor “materia prima”, como define Hupont a la información, mayor capacidad. “La base de datos privada más pequeña de una gran compañía es 12 veces mayor que la mayor base de datos pública. Y la tendencia es a no compartirlos”, advierte. Esta circunstancia es un lastre para el desarrollo de tecnologías eficaces por parte de la pequeña y mediana empresa sometidas a la gobernanza que propugna Europa, la cual se complementa con una apuesta por un Mercado Único de Datos en Europa

Puedes escribirnos a rlimon@elpais.es, seguir a EL PAÍS TECNOLOGÍA en Facebook y Twitter y apuntarte aquí para recibir nuestra newsletter semanal

Sobre la firma