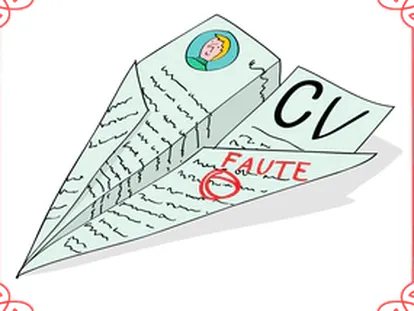

Así acaba el vídeo inocente de una niña en una lista erótica de YouTube

Un informe lleva a la plataforma a cerrar ocho listas de reproducción con nombres lascivos, pero las imágenes siguen siendo accesibles

Un informe del organismo catalán Consell de l'Audiovisual de Catalunya (CAC) detectó ocho listas de reproducción con vídeos de menores en YouTube con nombres como Culitos, Putillas o Hot teens.

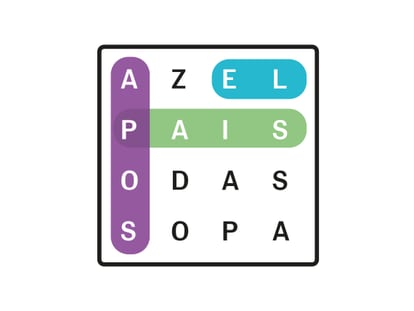

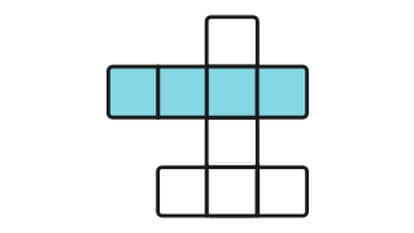

Estas listas recontextualizan los vídeos que una familia, un menor o un colegio han subido inocentemente a la plataforma. Les ponen un título nuevo, como Aquí una linda niña brasileña enseñando sus pasos de baile y los reúne con otros similares en una lista de título o contenidos más explícitos. Una lista de reproducción agrupa vídeos de contenido similar escogidos por un usuario.

YouTube anunció este miércoles que borraba esas listas: "Ningún tipo de contenido que pone en peligro a menores es aceptable en la plataforma y tenemos políticas claras que lo prohíben". La compañía, propiedad de Google, simplemente ha eliminado esas listas, cancelado las cuentas de sus autores y revisado manualmente cada uno de los vídeos. La mayoría de ellos, según YouTube, no viola sus políticas. Por tanto, siguen presentes, muchos con millones de visualizaciones.

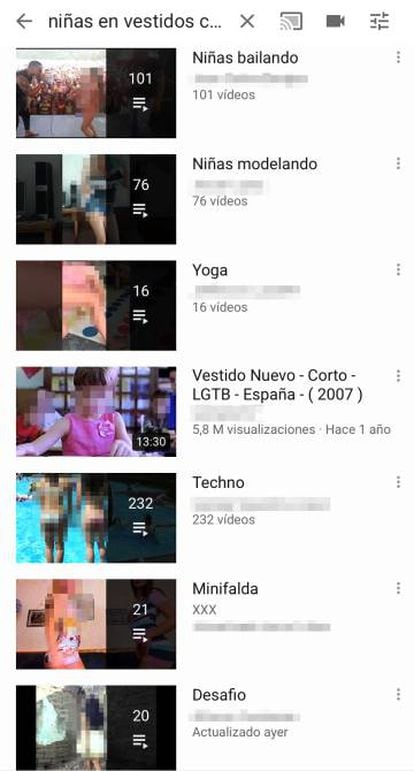

EL PAÍS comprobó lo fácil que era seguir encontrando esos vídeos que no violan las políticas de YouTube en un navegador no vinculado a una cuenta. Seguían todos ahí, con otras listas con nombres lascivos vinculados a montones de vídeos genuinos de niñas que juegan en una piscina y otros para adultos.

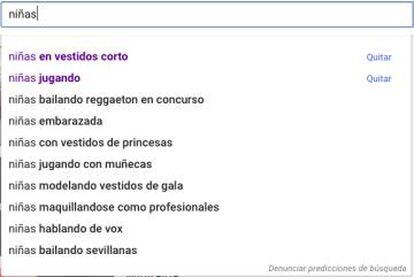

Pero no solo se comprobó que esos vídeos sobreviven a toda purga. El algoritmo de recomendación se puso enseguida a trabajar y detectó el potente interés de ese nuevo usuario anónimo por vídeos de niñas. Una búsqueda sin cambiar de navegador de ese usuario por "niñas" en YouTube devolvió una serie de recomendaciones terrorífica. El mismo buscador ofrecía la opción de "quitar" las dos primeras: "niñas en vestidos corto", "niñas jugando", "niñas bailando reggaetón en concurso", "niñas embarazada", "niñas con vestidos de princesa". El desfile ordenado de fantasías repugnantes es perceptible.

Tras clicar en "niñas en vestidos corto", la tercera opción es "Minifalda", creada por "xxx". La segunda es "yoga". Esa lista trae efectivamente lo que dice la palabra: una niña haciendo yoga. Pero en el fondo es la entrada hacia el inframundo a plena luz del día. El primer vídeo viene acompañado de algo raro en este magma: un anuncio de helados. Después del yoga, empiezan dos niñas a jugar al Twister. Sonríen, hacen piruetas, una mujer dice en español "ve dándote la vuelta para que graben por allá". Es todo tan ridículamente normal que parece imposible que tenga casi 3 millones de visualizaciones.

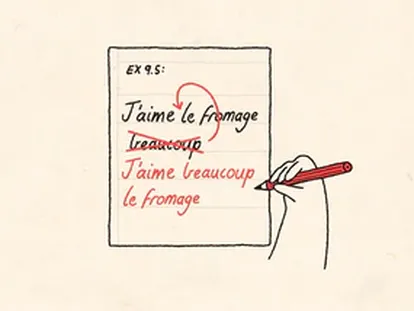

Pero el motivo va emergiendo. Luego viene otra niña: "Gimnasia en casa". Ya es imposible ver el siguiente con ojos aburridos: "Juegos de la silla colegio Santo Tomad", con la errata incluida. Aparecen adolescentes con el uniforme del cole, que es una minifalda muy corta. Son 2:11 minutos de algo anodino o de algo atroz, según como se mire. La lista tiene a continuación un vídeo privado y otro eliminado, lo que empieza a hacer sospechar. Pero en seguida todo este presunto horror encaja: "Hermosa colegiala rusa enseñando". Es solo el primero.

El contexto da todo el sentido: el título, los vídeos que lo rodean, el nombre del usuario. No es difícil deducir que eso no va de vídeos caseros sosos. De repente, unos vídeos malos de niñas gritando alrededor de una piscina como los de Verano azul se convierten en erotismo pernicioso. Todos son de golpe sugestivos de algo para lo que no fueron creados. Un vídeo de dos niñas que caen por un tobogán, patean el agua para mojar a un chico, se ponen de espaldas para tirarse a la piscina tiene más de 10 millones de reproducciones. Los ojos que observan ese vídeo miles de veces ven en el gesto infantil de sacar la lengua a cámara todo lo contrario.

El CAC quiso advertir a YouTube de un problema grave que veía en la plataforma, y que no ha encontrado en Vimeo o DailyMotion: "Conviene subrayar que en el momento en que se sube un contenido personal o familiar a una plataforma se pierde el control y la imagen de nuestros hijos o hijas puede acabar, sin saberlo, en una lista de tipo sexual", dice Roger Loppacher, presidente del CAC. En las ocho listas del CAC había 415 vídeos de los que 275 están protagonizados por menores y tienen casi 500 millones de visualizaciones. Es habitual que muchos de estos vídeos estén en varios canales a la vez.

Pero la respuesta de YouTube es como sacar un vaso de agua del mar para intentar vaciarlo. El pozo de basura es imposible de vigilar: "porno" pasa a ser "nopor", el código anodino de un vídeo pasa a ser un código donde hay docenas de vídeos de niñas en piscinas. El modo de comunicarse de los malos no deja de ir un paso por delante, con la ventaja de que se mueven en un océano de vídeos.

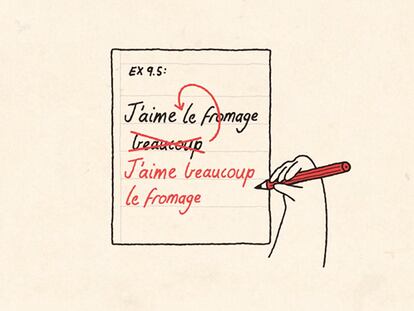

El vídeo 'Hermosa niña bailando Twerking para su hermano en la calle' tiene como comentario –escrito así– "Quantos años tiene"

YouTube sabe que esto ocurre. En febrero aparecieron varias piezas informativas de cómo pedófilos se comunicaban en los comentarios de vídeos de menores. YouTube eliminó la posibilidad de hacer comentarios en casi todos estos vídeos. No en todos: el vídeo Hermosa niña bailando Twerking para su hermano en la calle tiene el comentario "Quantos años tiene" (sic). Ese vídeo está en un canal llamado Vídeos del abuelo, que tiene una lista de reproducción titulada "niñas" y como descripción: "Este es un canal para todos aquellos que disfrutan de ver sensuales bailes, así como a sus actrices favoritas. suscríbanse que se vienen muchas mejoras y sorpresas". En el caso de esta cuenta los vídeos de la lista están recreados para poder cambiar el título y la descripción.

En junio, YouTube supo cómo el algoritmo de recomendación detectaba interés en niñas y ofrecía vídeos de niñas. Es algo que sigue ofreciendo, aunque quizá en español –y no en otras lenguas– tiene su propia vida. Uno de los métodos para evitar el abuso de estos vídeos es evitar que puedan ser monetizados con anuncios. También está hecho.

Alguien puede plantearse quién cuelga vídeos de menores en 2019. Se sorprendería. Al usuario anónimo creado por EL PAÍS, el algoritmo ya le recomendaba un canal enorme de dos gemelas brasileñas con los comentarios llenos de frases picantes.

YouTube ha cancelado los comentarios, ha desmonetizado los vídeos y ha eliminado los directos infantiles. Ha limitado, dice la plataforma, "las recomendaciones en vídeos que contienen menores en situaciones de potencial riesgo" y "tenemos políticas claras que van en contra de los vídeos y comentarios que sexualizan o explotan a menores de edad y nos tomamos en serio su cumplimiento cuando somos alertados sobre contenido peligroso".

¿Y cuando no son alertados? Llegará un día en que la única pregunta será si debe también impedir vídeos de menores. ¿Cómo puede borrar el contexto de esas imágenes, que está en manos de los usuarios desde la fundación de la plataforma?

Sobre la firma